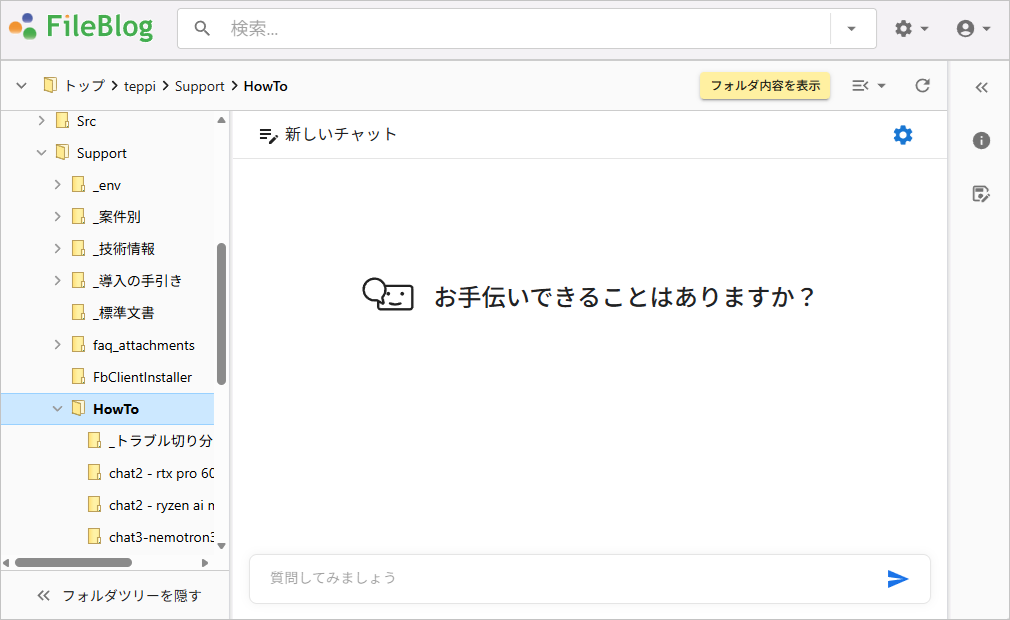

AIに対話形式で指示してファイルサーバー内文書の活用を進められます。

AIが質問や指示の意味を解釈して構造的に処理を行い、意図や文脈(コンテキスト)を考慮して回答を生成します。

機能概要

たとえば...次のようなことができるようになります。

- ファイル検索を自然文で指示:「○○の分析について書かれた文書を探して」

- ファイル内容の要約や翻訳

- 類似ファイルの内容比較

- 規定集やマニュアルなどから該当箇所を抽出

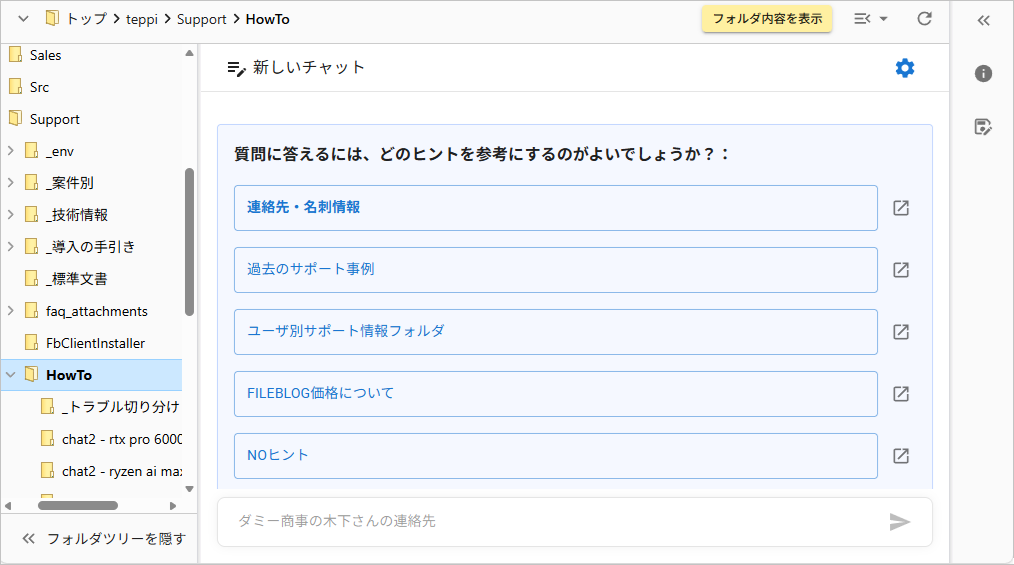

- 蓄積データ(サポート情報やトラブル情報など)からの情報収集

- 引用/参照ファイルの提示

特 長

- 会話から開始できる(前段に検索実行やファイル選択は不要)

- 質問内容に関連度が高い順で検索結果を表示(ベクトル検索に対応)

- ヒント(分岐プロンプト)を用意してAIへの質問をアシストできる(AIの回答精度UP)

- 使い方に応じてチャット画面を配置できる(特定フォルダに特化したチャット画面など)

- マルチプラットフォームまたはローカルのLLMに対応(ユーザーグループや文書特性に応じたLLM利用の設計ができる)

セキュリティ

- LLMはファイルサーバー内文書の学習はしません

- 実行ユーザー(ログインユーザー)のアクセス権限範囲の文書情報から回答生成

- ローカルLLMの利用でインターネット接続なしでもAI活用できます

対応するAIプロバイダー

| 実行プラットフォーム | LLM | 備考 |

|---|---|---|

| OpenAI | GPT | |

| Anthropic | Claude | |

| Azure OpenAI (Microsoft) | GPT | |

| Google Vertex AI (Google Cloud) | Gemini | |

| Amazon Bedrock (AWS) | Claude | |

| Ollma | gpt-ossなど | ローカル環境(テスト環境向け) |

| vLLM | gpt-ossなど | ローカル環境(本番環境向け) |

* AIプロバイダーとの個別契約が必要です

* ローカルLLMの運用にはLinuxサーバーが必要です